Last updated on 6월 19th, 2025 at 03:37 오후

구글 , 진짜가 왔다 : Gemini 2.5와 Stitch

구글 , 진짜가 왔다 : Gemini 2.5와 Stitch

구글 I/O 2025의 포문을 연 Josh Woodward는 Gemini 2.5 Pro와 Flash 모델의 업데이트를 소개하며, 이를 실험하는 공간인 구글 Labs의 역할을 강조했어요. 그중 하나인 ‘Stitch’는 사용자가 간단한 프롬프트만으로 앱 디자인과 코드를 빠르게 생성할 수 있게 해주는 도구예요. 예를 들어 ‘캘리포니아 여행 앱을 만들어줘’라고 입력하면, 실제로 디자인이 생성되고, 이걸 Figma로 옮기거나 바로 마크업 코드를 복사해 IDE에서 사용할 수 있어요. 실험적이지만 즉시 활용 가능한 프로젝트로, labs.구글/stitch에서 체험해볼 수 있습니다.

구글 , Gemini API로 음성 에이전트를?

다음 발표자 Logan은 구글 AI Studio에서 Gemini 2.5 Flash 모델을 활용해 음성 에이전트를 만드는 데모를 보여줬어요. 새로 추가된 기능으로는 ‘proactive audio’, 다국어 지원(24개 언어), 세션 컨텍스트 제어 등이 있어요. 또한 URL context라는 기능도 도입되었는데, 이는 웹 링크를 통해 최신 정보 기반으로 모델 응답을 유도할 수 있도록 돕습니다. 실제로 개발자 문서를 URL로 넘기면 TL;DR 요약을 Gemini가 제공하더라고요. 이 모든 기능은 실시간 API를 통해 바로 사용할 수 있어요.

구글은 됩니다 : Gemini와 함께하는 웹 앱 개발

Gemini 2.5 Pro는 AI Studio의 네이티브 코드 에디터에 통합되어 있어, 코드 작성과 오류 수정도 스스로 처리해줍니다. 예제로는 Gemini와 Imagen을 활용한 어드벤처 게임을 만들었고, 에러가 생겨도 모델이 자체 수정해서 완성된 앱을 보여줬어요. 또한 MCP(Multimodal Component Protocol) 정의를 SDK에서 직접 지원하게 되어, 구글 Maps 연동 앱도 쉽게 구현 가능해졌습니다.

구글, 이것까지 된다고? : Keynote Companion

Paige는 구글 Maps 앱을 리믹스해, 발표 내용을 실시간으로 듣고 반응하는 ‘Keynote Companion(KC)’라는 앱을 소개했어요. 발표자가 ‘Gemini’를 언급하면 카운트를 올리고, 실시간으로 지도 검색이나 커피숍 추천도 가능했죠. 음성 인식 기반으로 웹페이지가 실시간 반응하고, UI까지 자동 업데이트되는데 정말 놀라웠어요. 이 모든 걸 AI Studio에서 클라우드 런으로 배포해 라이브 앱으로 보여줬어요.

안드로이드에서는 역시 구글이 최고입니다

Diana와 Florina는 AI가 안드로이드 생태계에서 어떻게 새로운 앱 경험을 제공하는지 소개했어요. 예를 들어, 셀피를 찍으면 나만의 안드로이드 캐릭터를 만들어주는 ‘안드로이드ify’ 앱을 선보였는데, 이건 이미지 설명과 생성에 Gemini와 Imagen3를 사용했어요. 코드는 Firebase 기반으로 클라우드에서 실행되며, 겨우 몇 줄의 코드로 구현했더라고요. 그리고 이 앱은 GitHub에 오픈되어 있어요!

AI를 서버가 아닌 기기 내에서 실행할 수 있게 해주는 Gemini Nano도 소개됐습니다. 요약, 문장 수정, 이미지 설명 등 다양한 작업이 가능하며, 안드로이드 16에서는 UI 재설계와 함께 실시간 알림(Live Updates), 향상된 성능, 다양한 화면에 맞춘 적응형 디자인 등이 제공돼요. 특히 대형 화면이나 자동차, XR 기기에서도 동일한 앱을 사용할 수 있도록 기본적인 대응이 강화되었어요.

안드로이드 개발, 더 쉬워졌어요

Jetpack Compose는 안드로이드 개발의 생산성을 대폭 끌어올리고 있어요. 새 버전에는 자동완성, 텍스트 자동 크기 조절, 가시성 추적 등 다양한 기능이 추가되었고, Compose를 전체 UI에 적용할 수 있도록 CameraX, Media3 라이브러리도 Compose 기반으로 나왔습니다. 또한 안드로이드 Studio에서는 Gemini가 테스트 코드 작성이나 의존성 업데이트까지 도와줘서, 개발자가 반복적인 작업에서 벗어날 수 있도록 해줘요.

웹개발이 이렇게 달라집니다

Una와 Adi는 웹 개발에서의 변화들을 소개했어요. Chrome 135부터는 CSS만으로도 캐러셀, 툴팁, hover 카드 같은 복잡한 UI를 쉽게 구현할 수 있어요. Pinterest는 이 기능을 사용해 자바스크립트 2,000줄을 CSS 200줄로 줄였고, 성능이 크게 향상되었대요. DevTools에서는 AI 기능이 도입돼서, 버그의 원인을 설명해주고 코드 수정도 바로 적용할 수 있게 됐어요. Gemini Nano는 데이터가 디바이스를 벗어나지 않기 때문에 보안이 중요한 환경에서도 AI 기능을 쉽게 적용할 수 있어요.

Firebase Studio와 Figma도 더 좋아졌습니다

Firebase Studio는 프롬프트 한 줄로 풀스택 앱을 만들 수 있는 워크스페이스예요. Figma 디자인을 Builder.io 플러그인으로 export하면, 컴포넌트 단위로 나뉜 코드가 자동 생성되고, 필요한 경우 Gemini가 페이지 구조나 라우팅까지 알아서 설정해줘요. 백엔드가 필요한 경우엔 Firebase가 자동으로 인증, 데이터베이스 세팅도 해줘서, 빠른 프로토타이핑이 가능해졌습니다.

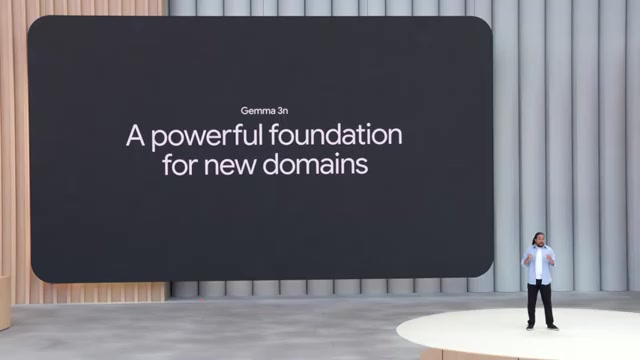

Gemma: 오픈모델과 커스터마이징

Gus는 오픈모델 Gemma에 대해 이야기했어요. 새로 공개된 Gemma 3n은 2GB RAM에서도 돌아가는 경량 모델인데, 오디오 이해 기능도 추가돼 진정한 멀티모달 모델이 되었어요. 특히, Colab과 UnSloth를 이용하면 Gemma를 빠르게 미세 조정할 수 있어서, 예를 들어 개인 이모지 언어를 이해하는 번역기도 만들 수 있어요. Gemma 기반 모델은 전 세계 70,000개 이상 만들어졌고, 인디언 언어, 수화(SignGemma), 심지어 돌고래 언어(DolphinGemma)까지도 지원한대요!

마지막엔 다시 Josh가 무대에 올라, 오늘 소개된 모든 혁신이 io.구글에서 확인 가능하다고 말하며 키노트를 마무리했어요. 함께한 발표자들과 함께 ‘Keynote Companion’의 반응을 들어보며, “우리가 함께 만드는 미래”에 대한 기대를 전했지요. 특히 이번 I/O는 AI가 ‘도구’를 넘어서 ‘동반자’가 되어가는 여정을 보여준 자리였어요.

구글 제미나이에 주목해야 할 지금!

아래 강의를 살펴봐주세요 🙂

.

.

.