Last updated on 6월 19th, 2025 at 03:37 오후

[사회자 소개]

[사회자 소개]

신사 숙녀 여러분, 엔비디아의 창립자이자 CEO이신 젠슨 황을 환영해주세요!

[젠슨 황]

타이완, 환영합니다! 저희 부모님도 오늘 관객석에 와 계십니다. 저기 계시네요. 정말 감사합니다. 엔비디아는 타이완에서 30년을 함께해왔습니다. 타이완은 저희에게 소중한 파트너이자 사랑하는 친구입니다.

지난 몇 년 동안 여러분은 엔비디아가 성장하는 모습을 함께 지켜봐 주셨죠. 우리는 놀라운 일들을 함께 해왔고, 수많은 활동을 함께했습니다. 오늘 저는 우리가 업계에서 어떤 위치에 있는지, 앞으로 어디로 나아갈지, 그리고 새로운 제품들을 소개하고, 우리에게 새로운 시장과 새로운 성장 기회를 열어줄 흥미롭고 놀라운 신제품들을 발표할 예정입니다.

우리는 훌륭한 파트너들과 함께 이 생태계를 어떻게 발전시켜 나갈지도 이야기할 거예요.

여러분도 아시다시피, 우리는 전 세계에서 가장 중요한 산업 중 하나인 컴퓨팅 생태계의 중심에 서 있습니다. 따라서 새로운 시장을 만들어야 할 때, 당연히 이 컴퓨터 생태계의 중심에서 시작해야겠죠.

그리고 오늘 여러분을 놀라게 할 몇 가지 깜짝 발표도 준비되어 있어요. 아마 여러분이 전혀 예상 못했을 것들도 있을 겁니다. 물론, AI에 대해서도 이야기할 겁니다. 로보틱스에 대해서도요.

[젠슨 황]

엔비디아의 이야기는 컴퓨터 산업의 ‘재창조’예요.사실, 엔비디아의 이야기는 곧 저희 회사의 재창조 그 자체이기도 합니다. 제가 이곳, 타이완에 오기 시작한 지 30년이 넘었어요. 많은 분들이 저의 키노트를 여러 번 들어주셨고, 어떤 분은 모든 키노트를 함께해 주셨죠. 그동안 우리가 나눴던 이야기들을 돌이켜보면, 우리가 얼마나 극적으로 변화했는지를 알 수 있습니다.

우리는 원래 칩 회사로 시작했어요. 새로운 컴퓨팅 플랫폼을 만드는 게 목표였죠. 2006년, 우리는 CUDA라는 기술을 선보였고, 이것이 컴퓨팅의 방식 자체를 완전히 혁신시켰습니다.

그로부터 10년 뒤인 2016년, 우리는 또 다른 ‘컴퓨팅의 전환점’이 찾아왔다는 걸 깨달았어요.

이 새로운 컴퓨팅 방식은 기술 스택의 모든 레이어를 재창조해야 했습니다.

- 프로세서도 새로워야 했고,

- 소프트웨어 스택도 새로워야 했으며,

- 시스템 전체 역시 새롭게 설계되어야 했어요.

그래서 우리는 새로운 시스템을 고안해냈죠.

2006년 GTC 행사에서 그 시스템을 발표했지만,

그 당시에는 아무도 제가 무슨 말을 하는지 이해하지 못했고,

어떤 고객도 구매 주문서(PO)를 주지 않았습니다. 😂

그 시스템의 이름은 바로 DGX-1이었어요.

저는 그 첫 번째 DGX-1을 비영리 단체인 OpenAI에 기증했습니다.

그것이 바로 AI 혁명의 시작이었죠.

몇 년이 지나 우리는 또 한 가지 중요한 사실을 알게 되었어요.

기존의 전통적인 소프트웨어 방식과는 전혀 다른 새로운 방식의 소프트웨어가 필요하다는 것이었습니다.

우리는 이 새로운 방식의 소프트웨어를 ‘인공지능’(AI)이라고 부르기 시작했죠.

예전의 애플리케이션은 거대한 데이터센터 안에서 몇 개의 프로세서만을 사용했습니다.

이걸 우리는 하이퍼스케일이라고 불러요.

하지만 인공지능 애플리케이션은 그렇지 않아요.

수많은 프로세서가 동시에 협업하면서,

수백만 명의 사용자 요청에 응답해야 하죠.

이런 애플리케이션을 위한 데이터센터는 근본적으로 다른 아키텍처가 필요했어요.

그래서 우리는 두 가지 종류의 네트워크가 필요하다는 걸 깨달았습니다:

- North–South 네트워크:

- 저장소 제어, 외부 연결 등 기존 시스템을 관리하기 위한 제어 네트워크

- East–West 네트워크:

- 컴퓨터들이 서로 연결되어 문제를 함께 해결하는 것이 핵심

- 엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

- CLICK!!

이때 우리는 East–West 트래픽에서 최고의 성능을 내는 네트워킹 회사를 발견했어요.

이때 우리는 East–West 트래픽에서 최고의 성능을 내는 네트워킹 회사를 발견했어요.

그 회사는 Mellanox라고 합니다.

우리에게 매우 소중한 파트너였고,

그래서 2019년에 그 회사를 인수했죠.

그 이후 우리는 데이터센터 전체를 하나의 거대한 컴퓨터 유닛으로 전환했습니다.

저는 이런 말을 한 적 있어요:

“현대의 컴퓨터는 곧 전체 데이터센터다.”

더 이상 단순한 PC나 서버가 아니라,

데이터센터 전체가 하나의 컴퓨터로 작동하는 시대가 온 거예요.

그리고 운영 체제도 이 흐름에 맞춰 완전히 바뀌게 되었죠.

[젠슨 황]

엔비디아의 데이터센터 여정은 이제 많은 분들이 알고 계세요.

지난 3년 동안, 우리는 아이디어를 현실로 만들었고,

회사를 바라보는 우리의 시각도 달라졌습니다.

역사상 어떤 기술 회사도,

앞으로 5년 동안의 로드맵을 공개한 적이 없어요.

대부분은 다음에 나올 제품을 비밀로 하죠. 아주 기밀스럽게 말이에요.

하지만 우리는 다르게 생각했어요.

이제 엔비디아는 단순한 기술 회사가 아닙니다.

우리는 이제 전 세계적으로 필수적인 인프라스트럭처(Infrastructure) 기업입니다.

그렇다면, 전 세계의 기업들이 인프라를 어떻게 계획할 수 있을까요?

- 땅을 확보하고,

- 전력을 연결하고,

- 건물을 짓고,

- 자금을 조달하고…

이런 큰 결정을 내리기 위해서는,

“엔비디아가 앞으로 뭘 만들지” 알아야 해요.

그래서 우리는 우리 회사의 기술 로드맵을 상세하게 공개하기로 했습니다.

전 세계 모든 이들이 그 정보를 바탕으로 데이터센터를 구축할 수 있도록 말이죠.

이제 우리는 명확히 말할 수 있어요:

우리는 AI 인프라 회사입니다.

전 세계 모든 지역, 모든 산업, 모든 기업이

이러한 AI 인프라를 구축하게 될 거예요.

📌 엔비디아 의 ‘지능형 인프라’

이 인프라는, 사실 과거의 산업 혁명과 비슷해요.

- 과거에 GE, 웨스팅하우스, 지멘스 같은 회사들이

전기라는 새로운 기술을 발견했을 때,

전 세계에 새로운 전력 인프라를 구축했죠.

그 인프라는 사회 인프라의 필수 요소가 되었고,

우리는 지금 그걸 ‘전기’라고 부릅니다. - 그 이후, 우리 세대에 또 하나의 인프라가 생겼습니다. 그건 바로 정보 인프라, 즉 인터넷이죠. 처음에는 아무도 이해하지 못했지만, 지금은 모든 것이 인터넷에 연결되어 있잖아요?

- 그리고 이제, 새로운 인프라가 등장했습니다.

지능 인프라(Intelligence Infrastructure) 입니다.

지금은 “지능 인프라”라는 말이 좀 생소하게 들릴 수 있어요.

하지만 제가 약속드릴게요. 10년 후에 돌아보면,

“AI는 이제 모든 곳에 통합돼 있다”고 느끼게 될 거예요.

모든 지역, 산업, 기업들이 AI를 필요로 하게 될 것입니다.

AI는 이제 인프라의 일부가 되었고,

이 인프라 역시 인터넷이나 전기처럼 공장을 필요로 합니다.

그 공장은 바로, 우리가 오늘 만들고 있는 것들입니다.

이건 더 이상 과거의 데이터센터가 아닙니다.

과거의 데이터센터는

ERP 시스템이나 기업의 사내 시스템을 위한

정보 저장소 역할을 했어요.

1조 달러(약 1,300조 원) 규모의 산업이죠.

하지만 오늘날 우리가 만들고 있는 건

AI 데이터센터, 그리고 이건 더 정확히 말하면

AI 팩토리입니다.

⚙️ AI 팩토리: 전기를 투입하면 ‘토큰(Token)’을 생산한다

이 새로운 AI 팩토리는 공장처럼 작동합니다.

- 에너지를 투입하면,

- 매우 가치 있는 무언가를 생산합니다.

그게 바로 토큰(Token)이에요.

기업들은 이제 “지난 분기에 우리가 얼마나 많은 토큰을 생산했는지” 이야기합니다.

곧 있으면, “우리는 시간당 몇 개의 토큰을 생산한다”고 말하게 될 거예요.

진짜 공장처럼요. 이건 세상이 완전히 바뀌었다는 뜻입니다.

💡 1993년의 엔비디아, 그리고 지금

회사를 처음 창업하던 1993년, 저는 엔비디아의 시장 기회를 계산해 봤어요.

결론은… 3억 달러(약 4,000억 원) 규모였죠. 그때 저는 생각했어요.

“와, 우리 부자 되겠는데?” 그렇게 그래픽 칩에서 시작한 우리는,

- 1조 달러 규모의 데이터센터 시장에 도달했고,

- 이제는 수조 달러 규모의 AI 인프라 산업으로 나아가고 있어요.

이게 바로 우리가 향하고 있는 흥미진진한 미래입니다.

[젠슨 황]

우리가 하는 모든 일의 중심에는 몇 가지 핵심 기술이 있습니다.

물론 제가 가속 컴퓨팅(accelerated computing)에 대해 자주 이야기하고,

AI에 대해서도 자주 말하지만…

사실 엔비디아를 특별하게 만드는 건

이 모든 능력이 융합되어 있다는 점이에요.

그리고 그 중에서도 가장 특별한 건,

우리가 만드는 알고리즘과 라이브러리입니다.

우리는 이걸 cuDAX 라이브러리라고 부르죠.

우리는 항상 라이브러리에 대해 이야기해요.

사실, 세상에서 라이브러리에 대해 이렇게까지 말하는 기술 회사는 우리밖에 없을 거예요.

그 이유는, 라이브러리야말로 모든 것의 시작이기 때문입니다.

오늘은 새로운 라이브러리 몇 개도 소개해드릴 건데요,

그 전에…

지금부터 보여드릴 영상에 대한 프리뷰부터 잠깐 보여드릴게요.

여러분이 곧 보게 될 모든 장면은,

시뮬레이션, 과학, 그리고 인공지능이에요.

예술적인 연출이 아닙니다.

이건 모두 시뮬레이션이에요.

단지 너무 아름다워서 예술처럼 보일 뿐이죠.

그럼 함께 보실까요?

🖥️ 실시간 컴퓨터 그래픽 데모

🖥️ 실시간 컴퓨터 그래픽 데모

[젠슨 황]

죄송합니다. 고맙습니다, 고맙습니다.

제가 지금 서 있는 이 화면은 실시간 컴퓨터 그래픽이에요. 비디오 영상이 아니라, 실제로 컴퓨터가 생성한 그래픽입니다. GeForce가 이걸 만들어내고 있어요. 이건 신형 GeForce RTX 5060입니다. Asus 제품이고요.

제 앞줄에 앉아 계신 제 친구 Johnny가 만든 제품이에요. 그리고 이건 MSI 제품입니다. 이 놀라운 GPU를 이 안에 집어넣었어요. 말이 되시나요? 진짜 대단하죠? 이게 바로 MSI의 새로운 노트북이고, 5060 GPU가 탑재돼 있어요.

🔍 딥러닝으로 만든 그래픽 – DLSS

GeForce는 CUDA를 세상에 소개했고,

지금 보시는 장면은 모든 픽셀이 레이 트레이싱(ray tracing)으로 생성되고 있어요.

도대체 어떻게 광자(빛)를 시뮬레이션하면서

이런 해상도와 프레임레이트를 유지할 수 있을까요?

그 이유는 바로 AI입니다.

사실, 지금 보시는 픽셀 중 10개 중 1개만 실제로 계산된 거예요.

나머지 9개는 AI가 ‘추측’한 겁니다.

이해되시나요?

그런데… 완벽합니다.

정말 완벽하게 예측해냈어요.

이 기술의 이름은 바로 DLSS (Deep Learning Super Sampling),

즉 신경망 기반 렌더링 기술이에요.

이걸 만들기까지는 수년이 걸렸어요.

우리는 AI를 시작한 그 순간부터 이 기술을 개발하기 시작했으니까요.

10년이 넘는 여정이었고,

결국 컴퓨터 그래픽의 혁신을 AI가 이끌게 된 거죠.

GeForce가 AI를 세상에 가져왔고,

이제는 AI가 다시 GeForce를 혁신시켰어요.

정말 놀라운 일이죠.

신사 숙녀 여러분, 이것이 바로 GeForce입니다.

🧒 젠슨 황에겐 자식과도 같은 (?) GeForce 지포스

CEO로서 저는 수많은 ‘자식’들이 있어요.

GeForce는 우리를 이 자리에 있게 해준 존재죠.

물론 지금은 저희 키노트의 90%가 GeForce가 아닌 다른 주제예요.

하지만 그건 GeForce를 사랑하지 않아서가 아니라,

GeForce가 너무나도 성공적이기 때문이에요.

최근 발표된 GeForce RTX 50 시리즈는

저희 역사상 가장 빠른 런칭,

가장 성공적인 출시였습니다.

PC 게이밍이 벌써 30년이 됐다는 점을 생각하면,

정말 대단한 성과라고 할 수 있어요.

GeForce를 통해 컴퓨터 그래픽의 미래를 보여드렸으니, 이제는 저희 기술의 핵심이라 할 수 있는 CUDA와 라이브러리에 대해 말씀드릴게요. 모든 것은 CUDA에서 시작합니다. CUDA를 가능한 한 높은 성능으로, 가능한 한 널리 퍼지도록 만든 덕분에, 이제 세계 곳곳 어디서나 CUDA GPU를 찾아볼 수 있어요.

설치 기반이 넓을수록 개발자들이 CUDA용 라이브러리를 만들고 싶어집니다. 라이브러리가 많아질수록 더 놀라운 애플리케이션이 생겨나고, 사용자들에게 더 많은 이익을 줍니다. 그러면 더 많은 사람들이 컴퓨터를 구매하고, 더 많은 CUDA가 세상에 퍼지게 되죠. 이 피드백 루프는 매우 중요해요.

하지만 가속 컴퓨팅은 범용 컴퓨팅과는 전혀 다릅니다. 범용 컴퓨팅에서는 대부분의 사람이 파이썬이나 C, C++로 코드를 작성하고 컴파일해서 CPU에 올리면 끝이에요. 소프트웨어 개발 방식이 일관되죠. 하지만 가속 컴퓨팅은 그런 식으로 작동하지 않아요. 그렇게 된다면 그냥 CPU에서 다 했겠죠. 굳이 다른 하드웨어를 만들 필요도 없었을 거예요.

그럼에도 불구하고 가속 컴퓨팅을 하는 이유는, 기존 CPU 방식만으로는 극적인 성능 향상이 어렵기 때문입니다. 수십 년간 수조 달러의 혁신이 쌓인 CPU 생태계를 단 몇 개의 칩셋으로 순식간에 50배, 100배 빠르게 만든다는 건 불가능하잖아요. 그래서 저희가 내린 결론은 이거였어요. 어떤 애플리케이션을 더 깊이 이해하면, 그것을 가속할 수 있다는 것. 실제 실행 시간의 대부분은 코드의 극히 일부에서 발생하는데, 그 핵심 부분만 가속하면 전체 성능을 크게 올릴 수 있습니다.

그래서 저희는 하나의 도메인씩 집중해서 공략하기 시작했어요. 조금 전엔 컴퓨터 그래픽 분야를 보여드렸고요, 이제 다른 예도 보여드릴게요.

쿠파이(KuPy)는 수치 계산에 가장 널리 쓰이는 라이브러리입니다. 아리엘(Ariel)과 쇼나(Shona)는 GPU로 가속하는 세계 최초의 5G 및 6G 무선 신호 처리 라이브러리에요. 여기에 AI를 얹으면, 이제 5G와 6G 통신망에 AI를 적용할 수 있게 되죠. 파라브릭스(Parabricks)는 유전체 분석을 위한 도구이고, 모니(Moni)는 의료 이미징에 사용돼요. 어스-2(Earth-2)는 기상 예측, 쿠퀀텀(KuQuantum)은 양자-고전 하이브리드 컴퓨팅 아키텍처를 위한 것이고, 쿠이퀴버리언스(KuEquivariance), 쿠텐서(KuTensor)는 텐서 수학을 위한 것입니다.

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

CLICK!

이 아래쪽 열은 모두 딥러닝과 관련된 라이브러리입니다. 학습과 추론 모두를 위한 필수 라이브러리들이죠. 이 혁신은 CUDA만으로 시작된 것이 아니라, cuDNN 위에 메가트론(Megatron)이 올라가고, 거기에 TensorRT-LLM이 더해지고, 최근에는 대형 AI 팩토리용 운영체제인 다이너모(Dynamo)까지 추가되었어요.

이 아래쪽 열은 모두 딥러닝과 관련된 라이브러리입니다. 학습과 추론 모두를 위한 필수 라이브러리들이죠. 이 혁신은 CUDA만으로 시작된 것이 아니라, cuDNN 위에 메가트론(Megatron)이 올라가고, 거기에 TensorRT-LLM이 더해지고, 최근에는 대형 AI 팩토리용 운영체제인 다이너모(Dynamo)까지 추가되었어요.

cuDF는 스파크(Spark)나 SQL처럼 구조화된 데이터를 다루는 데 쓰이고, cuML은 전통적인 머신러닝을 위한 라이브러리예요. WARP는 CUDA 커널을 파이썬 스타일로 묘사할 수 있는 프레임워크인데, 아주 성공적이죠. cuOpt는 복잡한 제약 조건이 많은 문제, 예를 들어 ‘외판원 문제’ 같은 걸 해결하기 위한 수학적 최적화 라이브러리입니다. 공급망 최적화에도 아주 유용하죠.

또한 cuSparse는 희소 행렬 구조 시뮬레이션을 위해 쓰이고, 이는 CAE나 CAD, 유체역학, 유한요소 해석, EDA 등에 꼭 필요합니다. cuLitho는 컴퓨팅 리소그래피(computational lithography)를 위한 아주 중요한 라이브러리인데, 마스크 제작에 한 달씩 걸리는 작업을 50~70배 더 빠르게 할 수 있게 해줘요. 이로 인해 앞으로는 리소그래피에 AI를 적용할 기반이 마련됩니다.

이 분야의 훌륭한 파트너들도 함께하고 있어요. TSMC는 cuLitho를 아주 적극적으로 사용하고 있고, ASML, Synopsys도 훌륭한 파트너로 참여하고 있습니다.

이처럼 다양한 분야의 과학과 물리 도메인을 가속할 수 있는 이유는, 단지 하드웨어 때문이 아니라 바로 이 라이브러리 생태계 덕분입니다. 덕분에 새로운 시장이 열리고, 새로운 기회를 창출할 수 있는 거죠.

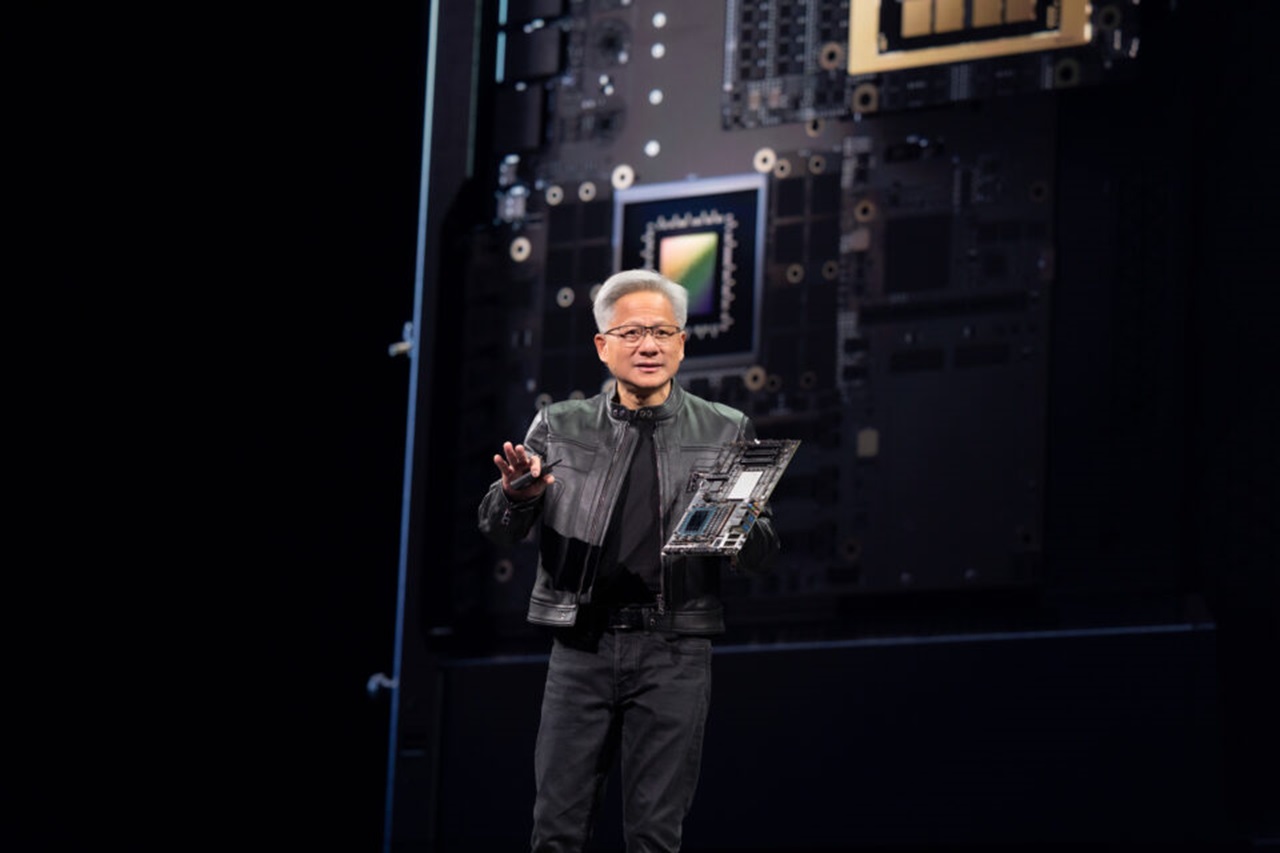

우리가 만드는 AI 공장의 핵심은 결국 ‘컴퓨터’예요. 지금까지와는 완전히 다른 성능과 구조를 가진 새로운 형태의 컴퓨터가 필요합니다. 그래서 우리가 만든 혁신적인 컴퓨터가 바로 Hopper였어요. 3년 전 세상에 처음 등장한 Hopper는 AI 세계를 완전히 뒤흔든 존재가 됐고, 아마도 지금 이 시대에서 가장 유명한 컴퓨터일 거예요.

그 이후 저희는 또 하나의 새로운 컴퓨터를 준비해 왔어요. AI가 추론할 때, 즉 실시간으로 생각하고 판단할 때 필요한 엄청난 연산량을 처리할 수 있도록, 훨씬 더 빠른 컴퓨팅이 가능해야 했죠. 왜냐하면 지금의 AI는 단순히 한 번 텍스트를 주고 답을 받는 ‘원샷 AI(one-shot AI)’ 수준을 넘어, 머릿속에서 수많은 토큰을 생성하고 생각을 여러 번 반복하며 답을 만들어내는 ‘생각하는 AI(thinking AI)’, ‘추론하는 AI(reasoning AI)’ 시대로 가고 있기 때문입니다. 그만큼 연산량이 폭발적으로 늘어나기 때문에, 완전히 새로운 시스템이 필요했던 거예요. 그래서 등장한 것이 바로 Grace Blackwell입니다.

Grace Blackwell은 크게 두 가지 특성을 갖고 있어요. 첫째는 스케일 업(scale up), 즉 한 대의 컴퓨터를 거대한 컴퓨터로 만드는 능력입니다. 둘째는 스케일 아웃(scale out), 즉 여러 대의 컴퓨터를 연결해 큰 작업을 분산 처리하는 능력이죠. 스케일 아웃은 비교적 쉬워요. 하지만 스케일 업, 즉 단일 컴퓨터를 반도체 물리 한계를 넘어서는 크기로 키우는 건 정말 어렵습니다. 그 어려운 일을 Grace Blackwell이 해냈어요.

Grace Blackwell 기반의 시스템은 지금 이미 풀 프로덕션(완전 생산 체제)에 돌입했고, 몇몇 클라우드 서비스 제공업체(CSP)들은 벌써 이 시스템을 사용 중입니다. 올해 3분기에는 새로운 업그레이드 모델인 GB300도 출시될 거예요. 외형이나 구조는 동일하지만, 내부에 탑재된 Blackwell 칩이 새로워졌어요. 이전보다 추론 성능은 1.5배, HBM 메모리는 1.5배, 네트워킹 성능은 2배 향상됐습니다. 이 모든 게 그대로 기존 섀시와 시스템에 꽂아 쓸 수 있도록 설계돼 있어요.

Grace Blackwell 시스템의 연산 성능은 40 페타플롭스(PFLOPS)에 달합니다. 이건 2018년 기준 미국의 Sierra 슈퍼컴퓨터와 동일한 수준이에요. 그런데 Sierra는 18,000개의 GPU로 구성돼 있었지만, Grace Blackwell은 단 1개 노드만으로 그 성능을 내는 거죠. 6년 만에 성능이 4배 향상된 겁니다. 이건 말 그대로 극한의 무어의 법칙(extreme Moore’s Law)이에요.

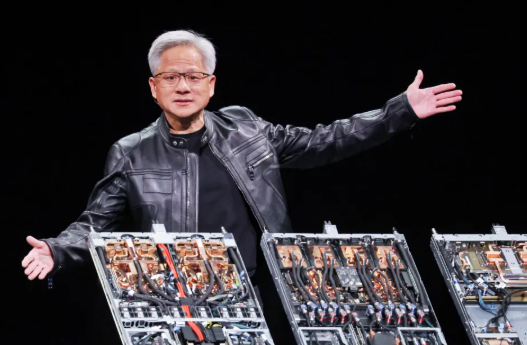

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

이 성능을 가능하게 한 핵심은 바로 NVLink라는 기술입니다. NVLink는 엔비디아가 설계한 세계에서 가장 빠른 스위치형 연결 구조예요. NVLink Spine이라는 이 구조물은 거의 70파운드(약 32kg)나 되는 무게인데, 그 안에 2마일(약 3.2km)에 달하는 5,000개의 구리 케이블이 정교하게 연결되어 있어요. 이 NVLink Spine 하나로 연결된 모든 GPU는, 서로 동시에, 전속력으로 통신할 수 있습니다. 그 대역폭은 무려 130TB/s, 인터넷 전체의 피크 트래픽보다도 더 높아요.

그런데 물리적으로 너무 많은 데이터를 너무 먼 거리로 보내야 하다 보니, 결국 모든 GPU를 하나의 랙(rack) 안에 넣을 수밖에 없었습니다. 그래서 지금의 Grace Blackwell 시스템은 랙 하나가 120킬로와트에 달하는 전력을 소비하고, 전부 액체 냉각 방식(liquid cooling)으로 냉각돼야 해요. 이 랙 전체가 마치 한 장의 마더보드처럼 동작합니다. 완전히 분산되면서도, 동시에 하나처럼 작동하는 컴퓨터 구조죠.

이런 시스템은 단순한 데이터센터를 위한 것이 아닙니다. 우리는 지금 AI 팩토리를 만들고 있는 중이에요. 실제로 Oracle Cloud, CoreWeave 등은 이 시스템을 적용해 AI 팩토리를 구축하고 있고, xAI의 Colossus 공장, Stargate 프로젝트 같은 어마어마한 규모의 AI 슈퍼컴퓨터 공장도 이미 준비 중이에요. 예를 들어, 1기가와트급의 공장은 6조~10조 원이 들고, 이 중 절반 이상이 Grace Blackwell 같은 컴퓨팅 장비로 채워질 겁니다.

구글 I/O 2025의 포문을 연 Josh Woodward는 Gemini 2.5 Pro와 Flash 모델의 업데이트를 소개하며, 이를 실험하는 공간인 구글 Labs의 역할을 강조했어요. 그중 하나인 ‘Stitch’는 사용자가 간단한 프롬프트만으로 앱 디자인과 코드를 빠르게 생성할 수 있게 해주는 도구예요. 예를 들어 ‘캘리포니아 여행 앱을 만들어줘’라고 입력하면, 실제로 디자인이 생성되고, 이걸 Figma로 옮기거나 바로 마크업 코드를 복사해 IDE에서 사용할 수 있어요. 실험적이지만 즉시 활용 가능한 프로젝트로, labs.구글/stitch에서 체험해볼 수 있습니다.

[젠슨 황]

이 기술이 얼마나 복잡한지, 지금 이 무대에서 직접 설명만으로는 그 진짜 깊이를 다 전달할 수 없을 거예요. 그래서 여러분을 위한 영화를 하나 준비했습니다. Grace Blackwell이 어떻게 탄생하는지, 직접 눈으로 확인해보세요.

엔비디아 블랙웰의 탄생기를 봅시다

엔비디아 블랙웰의 탄생기를 봅시다

🎬 [영상 설명 – 블랙웰의 탄생]

Blackwell은 그 자체로 하나의 공학적 경이로움(engineering marvel)입니다. 모든 것은 TSMC의 빈 실리콘 웨이퍼에서 시작돼요. 수백 단계의 칩 가공 공정과 극자외선(EUV) 리소그래피 기술을 통해, 12인치 웨이퍼 위에 2천억 개의 트랜지스터가 층층이 쌓입니다.

이 웨이퍼는 조각(scribe)되어 개별 다이(die)로 분리되고, 테스트를 통해 양품(good die)만을 선별한 후 다음 공정으로 넘어갑니다. 이후 TSMC, SPIL, Amkor 같은 파운드리들이 협력해 ‘칩 온 웨이퍼 온 서브스트레이트(COWOS)’ 공정을 진행합니다. 이 과정에서, 하나의 커스텀 실리콘 인터포저 위에 32개의 Blackwell 다이와 128개의 HBM 메모리 스택이 정교하게 배치됩니다. 그 사이사이를 연결하는 금속 인터커넥트(금속 연결선)들이 직접 새겨져요.

모든 부품이 제자리에 고정되면, 조립체는 고온에서 굽고(bake), 몰딩하고(mold), 경화(cure)하는 과정을 거쳐 Blackwell B200 슈퍼칩이 완성됩니다.

KYEC에서는 이 Blackwell 칩들을 125도 이상의 고온 오븐에 넣고, 몇 시간 동안 한계까지 스트레스 테스트를 합니다.

이후에는 Foxconn의 공장에서 자동화 로봇들이 24시간 쉬지 않고 Grace Blackwell 메인보드에 1만 개 이상의 부품을 픽앤플레이스 방식으로 장착해요. 동시에 세계 곳곳의 공장에서 추가 부품들도 생산되고 있죠. Cooler Master, AVC, AORUS, Delta 같은 파트너들은 액체 냉각용 구리 냉각 블록을 제작해 Grace Blackwell 칩의 온도를 최적 상태로 유지해줍니다.

다른 Foxconn 시설에서는 네트워킹용 ConnectX-7 SuperNIC, 보안 및 스토리지 가속을 위한 BlueField-3 DPU도 조립됩니다. 이 모든 부품은 GB200 시스템에 정교하게 통합되죠.

NVLink는 이 시스템을 하나의 거대한 가상 GPU로 만드는 핵심 기술입니다. NVLink 스위치 트레이는 엔비디아가 개발한 스위치 칩들로 구성되어 있으며, 초당 14.4TB의 전면 통신 대역폭을 제공합니다. 이 트레이들은 5,000개의 구리 케이블로 이루어진 NVLink Spine을 통해 모두 연결됩니다. 이렇게 해서 총 72개의 Blackwell GPU, 즉 144개의 GPU 다이가 완전히 하나의 초대형 GPU로 작동하게 되는 거예요.

Foxconn, Wistron, Quanta, Dell, Asus, Gigabyte, HPE, Supermicro 같은 전 세계 파트너들이 부품을 공급하고, 숙련된 기술자들이 이 부품들을 조립해 하나의 랙 규모 AI 슈퍼컴퓨터가 완성됩니다. 이 한 대의 시스템에는 약 120만 개의 부품, 2마일의 구리 케이블, 1,300억 개의 트랜지스터가 들어갑니다. 무게는 무려 1.8톤에 달하죠.

처음 실리콘에 트랜지스터를 새기는 순간부터 마지막 볼트를 조이는 순간까지, 이 모든 과정에는 파트너들의 헌신, 정밀함, 그리고 장인정신이 담겨 있습니다.

Blackwell은 단순한 기술의 집합이 아닙니다. 타이완 기술 생태계의 위대함을 증명하는 상징이기도 하죠. 저희는 이 성과를 타이완과 함께 이루어낸 것을 매우 자랑스럽게 생각합니다.

[젠슨 황]

타이완은 단지 전 세계의 슈퍼컴퓨터를 만드는 데 그치지 않습니다. 오늘 저는 아주 기쁜 마음으로 발표합니다. Foxconn, 타이완 정부, 엔비디아, 그리고 TSMC가 협력해 타이완 현지에 최초의 대형 AI 슈퍼컴퓨터를 건설할 예정입니다. 타이완의 AI 인프라와 생태계를 위한 프로젝트예요.

혹시 이 자리에 계신 분들 중 AI 컴퓨터가 필요하신가요? AI 연구자 분들? 모든 학생, 연구자, 과학자, 스타트업, 그리고 대기업들이 이런 인프라를 필요로 하게 될 겁니다. 사실 TSMC는 이미 엄청난 규모의 AI와 과학 연구를 진행 중이고, Foxconn도 로보틱스 관련 방대한 프로젝트들을 추진하고 있어요. 지금 이 자리에 앉아 계신 여러분들 중에서도 AI와 로봇 연구를 하고 계신 분들이 많을 거예요.

그렇기 때문에, 타이완에 세계적 수준의 AI 인프라를 구축하는 일은 정말 중요한 과제입니다. 그리고 그 핵심이 되는 게 바로 Blackwell 시스템을 기반으로 한 서버들이에요. 이건 단순한 컴퓨터가 아닙니다. 각 파트너사들이 만든 시스템 하나하나는 Blackwell 칩을 모아 하나의 거대한 칩처럼 동작하게 만드는 장치죠.

Pegatron, QCT, Wistron, WeWin, Foxconn, Gigabyte, ASUS 등등 수많은 파트너사들이 이 시스템을 만들고 있어요. 전면과 후면 모두 완전히 새로운 구조로 설계돼 있고, 전부 Blackwell 칩을 대규모로 연결해 하나의 연산 단위로 통합할 수 있도록 설계돼 있죠.

이게 가능해진 건 NVLink 덕분입니다. 하지만 단지 NVLink만 있다고 되는 건 아니에요. 정교한 시스템 아키텍처, 완성도 높은 소프트웨어 생태계, 150개 이상의 회사들이 함께한 협업 구조가 있었기 때문에 가능한 일이었습니다. 이 아키텍처는 지난 3년간의 산업적 협력과 기술 혁신이 만들어낸 성과예요.

💡 누구나 AI 인프라를 만들 수 있도록, NVLink Fusion 공개

💡 누구나 AI 인프라를 만들 수 있도록, NVLink Fusion 공개

저희는 이제 이 기술을 누구나 사용할 수 있도록 개방하려고 합니다. 오늘 발표할 새로운 기술은 바로 엔비디아 NVLink Fusion입니다. 이건 더 이상 ‘반맞춤형 칩(semi-custom chip)’이 아니라, 반맞춤형 AI 인프라(semi-custom AI infrastructure)를 누구나 만들 수 있게 해주는 구조예요.

각 기업은 자신만의 특화된 인프라를 구성할 수 있습니다. 어떤 회사는 CPU가 많을 수도 있고, 어떤 회사는 엔비디아 GPU가 많을 수도 있겠죠. 혹은 다른 종류의 특수 목적 칩(ASIC)을 사용하고 싶을 수도 있어요. 문제는, 이 모든 시스템들을 연결해주는 공통의 연결 고리가 필요하다는 겁니다. 바로 그 핵심이 NVLink예요.

NVLink Fusion을 활용하면, 자신만의 칩(예: TPU나 특수 ASIC)을 엔비디아 플랫폼에 연결할 수 있어요. 저희는 여러분의 칩에 NVLink 칩렛(chiplet)이라는 작은 스위치를 직접 붙일 수 있게 설계했고, 필요한 경우 NVLink 인터페이스용 IP도 제공합니다. 이렇게 하면, 여러분의 칩도 엔비디아의 거대한 슈퍼컴퓨터 생태계에 바로 연결될 수 있어요.

CPU도 마찬가지예요. 여러분이 직접 만든 CPU가 있다면, 엔비디아 생태계에 통합할 수 있는 NVLink 인터페이스를 제공해드립니다. 그렇게 되면 여러분의 CPU, 여러분의 시스템도 Blackwell 및 향후 Rubin 세대와 연결되어 거대한 컴퓨팅 시스템으로 통합될 수 있어요.

결과적으로, 각 회사는 자신의 칩을 포함한 다양한 구성으로 AI 인프라를 구축할 수 있고, 동시에 엔비디아의 생태계와 완벽히 연결된 NVLink 기반 네트워크 인프라를 그대로 활용할 수 있게 되는 거예요.

🧩 함께하는 파트너사들

이번 NVLink Fusion 생태계에는 이미 많은 파트너가 함께하고 있어요. Astera Labs, Marvell, MediaTek은 hyperscaler와 특수 ASIC 고객을 위한 파트너로서 협력 중이고, Fujitsu, Qualcomm은 자사 CPU를 엔비디아와 통합하고 있습니다. Cadence, Synopsys는 NVLink 칩렛 IP를 고객에게 이전할 수 있도록 준비돼 있고요.

NVLink Fusion을 통해 여러분이 이 생태계에 참여하면, 즉시 엔비디아 전체 슈퍼컴퓨터 아키텍처에 통합될 수 있는 권한이 생깁니다. 말 그대로 여러분이 설계한 시스템이 엔비디아의 거대한 슈퍼컴퓨터 일부가 될 수 있는 거죠.

여러분께 이제 새로운 제품 카테고리를 소개할 차례입니다.

지금까지 몇 가지 컴퓨터를 보여드렸지만, 사실 세상의 다양한 수요를 충족시키기엔 아직 부족해요. 그래서 더 많은 컴퓨터가 필요합니다.

우선 먼저 업데이트부터 드릴게요. 새로운 컴퓨터 DGX Spark가 이제 완전 생산 체제(Full Production)에 들어갔습니다. 곧 몇 주 안에 출시될 예정이에요. 이 시스템은 개발자, 학생, 연구자 등 AI 네이티브 개발자들을 위해 설계된 제품입니다.

DGX Spark는 항상 켜져 있고, 항상 대기 중인 나만의 클라우드 AI 개발 환경이에요. 클라우드를 켜고 끄고, 세팅하고 스크럽하는 번거로운 과정을 거칠 필요 없이, 그냥 바로 옆에 있는 AI 서버에서 직접 실험하고 개발할 수 있죠. 프로토타이핑과 초기 개발에 정말 최적화돼 있어요.

더 놀라운 건, 이 작은 기기가 1 페타플롭스의 연산 성능과 128GB 메모리를 갖추고 있다는 거예요. 참고로 2016년에 제가 발표했던 최초의 DGX-1도 같은 성능이었어요. 그때 DGX-1은 300파운드나 됐고, 두 팔로 들지도 못했죠. 지금 이 Spark는 겨우 손바닥만 한 크기인데, 성능은 거의 비슷합니다. 단, 메모리는 HBM이 아니라 LPDDR5X이긴 해요.

이제 이 정도 성능의 AI 슈퍼컴퓨터를 누구나 하나쯤은 크리스마스에 갖게 될 수 있다는 거죠. (웃음)

🖥️ 더 강력한 개인용 AI 컴퓨터: DGX Station

Spark보다 더 강력한 AI 컴퓨터가 필요하신가요? 여기 있습니다. 이건 여러분의 개인용 데스크 사이드 DGX 슈퍼컴퓨터입니다. Dell, HP, ASUS, Gigabyte, MSI, Lenovo, Lambda, Box 같은 워크스테이션 전문 기업들이 함께 판매할 거예요.

이 컴퓨터는 일반 벽면 콘센트에서 뽑아낼 수 있는 최고 수준의 성능을 갖고 있어요. 단, 주방에 설치하신다면 전자레인지와 함께 사용하면 아슬아슬할 수도 있죠. (웃음) 이게 가정용 전력 한계선이라고 보시면 돼요.

프로그래밍 모델은 기존에 보여드린 대형 슈퍼컴퓨터들과 완전히 동일합니다. 하나의 아키텍처, 하나의 소프트웨어 구조로 작동하죠. 이 시스템은 무려 1조 개의 파라미터 모델도 돌릴 수 있을 만큼 강력해요. 예를 들어 Llama 70B의 경우 700억 파라미터인데, 이건 1조 파라미터 모델도 거뜬하다는 이야기입니다.

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

🧠 AI 네이티브 컴퓨터란?

중요한 건, 이 컴퓨터들이 기존의 서버와는 다르다는 거예요. 이건 AI 네이티브(AI Native) 컴퓨터입니다. 다시 말해, 기존 IT 환경에서 사용하는 x86 아키텍처, 하이퍼바이저, 윈도우 OS, 전통적인 애플리케이션을 꼭 실행할 필요가 없다는 뜻이에요. 이 시스템은 오직 현대의 AI 애플리케이션을 위해 설계된 컴퓨터입니다.

물론 전통적인 시스템에서도 이 AI 기능들을 API 형태로 불러 쓸 수 있어요. 하지만 우리가 진정 원하는 미래는, 기업의 전통적인 IT 환경 속으로 AI를 통합하는 것입니다.

기업 IT는 사실 크게 세 가지 계층으로 구성돼 있죠: 컴퓨팅, 스토리지, 네트워킹. 이 세 가지 모두가 AI에 맞춰 완전히 재설계되어야 합니다.

기업 IT 환경은 단순히 컴퓨터만 있는 게 아닙니다. 항상 세 가지 계층으로 나뉘죠: 컴퓨팅, 스토리지, 네트워킹. AI가 모든 산업을 바꾸고 있는 지금, 당연히 이 세 가지 계층도 완전히 새롭게 설계되어야 합니다. 특히 우리는 이 새로운 환경에 맞는 엔터프라이즈용 AI 컴퓨터가 필요했어요. 그래서 오늘 소개하는 것이 바로 RTX Pro Enterprise입니다.

이 컴퓨터는 모든 것을 실행할 수 있는 서버예요. 물론 x86 기반으로 전통적인 하이퍼바이저(VMware, IBM Red Hat, Nutanix 등)도 실행할 수 있고, 쿠버네티스 클러스터와 가상 데스크톱 환경도 운영할 수 있어요. 즉, 여러분 IT팀이 현재의 인프라를 관리하던 그대로 관리할 수 있습니다. 동시에 이 시스템은 완전히 새로운 AI 네이티브 기능도 실행할 수 있어요.

RTX Pro 서버는 단순히 텍스트 기반의 AI뿐 아니라, 그래픽 기반의 AI도 실행할 수 있습니다. 예를 들면, 작은 ‘디지털 젠슨’이 여러분 앞에 등장해서 도와주는 것처럼요. (웃음) 말 그대로 디지털 에이전트들이 텍스트든 영상이든 그래픽이든, 어떤 형식으로든 작동할 수 있는 환경을 제공합니다. 그리고 무엇보다도, 우리가 알고 있는 거의 모든 AI 모델과 애플리케이션이 여기에서 작동합니다. 참고로, Crysis도 돌아가요. (웃음)

💾 새로운 네트워크 아키텍처: CX8

RTX Pro 서버 내부를 살펴보면, 8개의 Blackwell RTX Pro 6000 GPU가 CX8이라는 새로운 마더보드에 연결되어 있어요. 이 CX8은 기존의 네트워크 칩과는 다릅니다. CX8은 스위치이자 네트워킹 칩이며, 동시에 현재까지 가장 진보된 기술을 담은 제품이에요.

각 GPU는 PCIe를 통해 CX8에 연결되고, 각 GPU에는 전용 네트워크 인터페이스가 탑재되어 있어요. 이를 통해 GPU 간에 동시 다발적인 동서향 통신(East-West traffic)이 가능해져, AI가 요구하는 초고속 추론, 훈련, 상호작용 처리를 실현할 수 있어요. 대역폭은 무려 800Gbps에 달합니다.

AI 팩토리를 성능으로 측정할 땐 두 가지가 중요해요.

- 토큰/초 (Throughput): 공장에서 초당 얼마나 많은 토큰을 생성하느냐

- 사용자당 토큰/초 (Interactivity): 한 명의 사용자에게 얼마나 빠르게 응답하느냐

기존 공장 시스템은 둘 중 하나만 잘하는 경우가 많아요. 하지만 RTX Pro는 두 가지를 모두 가능하게 만들어줍니다. 이를 위해 파이프라인 병렬 처리, 전문가 병렬 처리, 배치 처리, 추론 방식 최적화 등 다양한 알고리즘을 조합해서 최적화합니다.

이 모든 성능을 한눈에 보여주는 게 바로 토큰 처리 곡선 그래프입니다. 이 곡선의 외곽 면적이 클수록, AI 팩토리의 성능이 뛰어나다는 뜻이에요.

🔍 DeepSeek R1과의 비교

지금까지 가장 잘 알려진 AI 팩토리 시스템은 H100 기반의 HGX였습니다. 약 22만 5천 달러의 고성능 서버였죠. 그런데 오늘 보여드린 Blackwell 기반 RTX Pro 엔터프라이즈 서버는, 이보다 성능이 1.7배 뛰어납니다.

그리고 가장 인상적인 건, DeepSeek R1이에요. DeepSeek R1은 최신 추론 기술과 컴퓨터 과학적 돌파구를 기반으로, H100보다 무려 4배 높은 성능을 기록했어요. 이 모델은 전 세계 연구자들에게 AI 추론, 추론 최적화, 그리고 AI 팩토리 설계에 대한 새로운 인사이트를 주는 진정한 혁신입니다.

RTX Pro는 단순한 컴퓨터가 아니에요. AI를 엔터프라이즈에 본격적으로 통합할 수 있는 시스템이고, 지금까지 엔비디아가 출시한 컴퓨터 중 가장 광범위한 생태계와 함께 출시되는 제품입니다. 모든 주요 파트너사들과 함께 이 플랫폼을 시장에 내놓을 예정이에요.

AI가 본격적으로 기업 환경에 들어오려면, 컴퓨팅만 바꿔서는 안 돼요. 스토리지도 완전히 새롭게 설계돼야 하죠. 기존 IT에서는 데이터베이스를 질의할 때 SQL처럼 구조화된 데이터를 기준으로 쿼리해왔어요. 그런데 AI는 그 방식과 다릅니다. AI는 ‘의미’ 기반으로 데이터를 찾고 싶어 해요. 문장, 이미지, 오디오, 텍스트 등 비정형 데이터(Unstructured Data)를 이해하고 처리하는 방식이 필요한 거죠.

이제부터는 스토리지 위에 AI가 직접 올라타는 구조가 필요합니다. 그래서 저희가 만든 것이 바로 엔비디아 AI 데이터 플랫폼, 그리고 이 플랫폼 위에서 작동하는 쿼리 시스템 엔비디아 AIQ입니다.

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

💾 CPU가 아니라 GPU가 데이터

지금까지 스토리지는 CPU가 서버에 올라타서 데이터를 다뤘어요. 하지만 앞으로는 그 앞에 GPU가 서게 될 것입니다. 이유는 간단해요. 비정형 데이터를 AI가 처리하려면, 단순한 저장이 아니라 의미 추출, 인덱싱, 검색, 랭킹 등 엄청난 연산이 필요하거든요. 이건 GPU가 훨씬 더 잘합니다.

그래서 앞으로의 스토리지 시스템은, 그 앞단에 반드시 GPU 기반 컴퓨팅 노드가 배치될 거예요. 저희는 이를 위해 수많은 AI 모델을 개발했고, 오픈 AI 모델들을 안전하고 투명한 방식으로 후학습(Post-training)하여 제공하고 있어요. 이 모델들이 여러분이 구축하는 AI 플랫폼의 핵심이 됩니다.

📊 엔비디아 AIQ와 NEMO: 빠르고 정밀한 검색 시스템

지금 다운로드 가능한 오픈소스 AI 모델 중에서, 추론 성능이 가장 뛰어난 모델은 Llama NEMOTRON Reasoning Model이에요. 이 모델은 저희가 만든 NEMO 프레임워크를 통해 완성됐고, 성능과 정확도 모두 업계 최고 수준입니다.

또한 AIQ에는 의미 기반 검색을 가능하게 해주는 검색 모델들이 함께 들어있어요. 성능은 업계 대비 15배 빠르고, 쿼리 정확도는 50% 더 뛰어납니다. 이 시스템은 오픈소스로 설계되었고, 누구나 직접 구축할 수 있는 AIQ 블루프린트도 제공됩니다.

예를 들어 VAST는 엔비디아 AIQ 블루프린트를 기반으로, 단 3일 만에 세일즈 전략을 짜주는 AI 에이전트를 개발했어요. 이 에이전트는 CRM 시스템, 멀티모달 지식베이스, 내부 도구에서 데이터를 불러와 의미를 추출하고, NEMOTRON을 통해 구체적인 세일즈 플랜을 생성해줍니다. 예전에는 수일이 걸리던 업무가, 이제는 프롬프트 한 줄로 몇 분 만에 끝나요.

이제 기업은 모든 직원마다 자신만의 AI 에이전트를 둘 수 있게 됩니다. ‘데이터를 읽고 요약하고 실행 가능한 지식으로 바꿔주는 AI 비서’가 실현되는 거예요.

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

🤝 함께하는 스토리지 파트너들

이런 새로운 AI 기반 스토리지 플랫폼을 함께 구축 중인 파트너도 많습니다.

- Dell: 자체 AI 데이터 플랫폼 개발 중

- Hitachi: 자사 플랫폼에 엔비디아 AIQ 통합

- IBM: NEMO와 함께 AI 스토리지 솔루션 구축

- NetApp: 구조화 + 비정형 데이터 통합 플랫폼 개발 중

이처럼, AIQ는 이제 거의 모든 주요 스토리지 기업과 협력하고 있으며, 여러분이 만들고 싶은 AI 스토리지 시스템의 기반이 되어줄 수 있어요.

이제 AI는 엔터프라이즈 IT에 본격적으로 들어왔어요. 그럼 다음으로 필요한 건 무엇일까요? 바로 이 AI 시스템들을 운영·관리하는 새로운 체계, 즉 AI Ops(AI Operations)입니다. 기존의 기업들은 공급망에는 ‘SCM’, 인사에는 ‘HR’, 그리고 보안에는 ‘SecOps’가 있었죠. 이제는 AI 에이전트를 관리하고 최적화하는 전담 부서, 즉 IT 내에서의 AI Ops 조직이 필요해지는 시대입니다.

이 부서는 다음과 같은 일들을 맡게 될 거예요:

- 데이터를 큐레이션하고,

- AI 모델을 파인튜닝하고,

- 모델의 성능을 평가하고,

- 가드레일과 보안 체계를 적용하고,

- 다양한 역할의 에이전트들을 지속적으로 운영, 배포, 개선합니다.

🛠️ 엔비디아의 AI Ops 툴 체계: 모델과 라이브러리

AI Ops를 가능하게 하는 툴도 엔비디아가 준비해뒀어요. 저희는 AI Ops 환경에서 필요로 하는 다음과 같은 기능들을 위한 라이브러리와 모델들을 제공합니다:

- 모델 파인튜닝

- 보안 및 액세스 제어

- 에이전트 행동 추적

- 성능 로그 분석

- 역할 기반 에이전트 배포 등

이 모든 것을 통합적으로 관리할 수 있는 프레임워크가 준비되어 있고, 다양한 파트너들과 함께 생태계를 확장하고 있어요.

함께하는 AI Ops 파트너사들

AI Ops 생태계도 굉장히 활발하게 확장 중입니다. 엔비디아는 아래와 같은 훌륭한 파트너들과 협업하고 있어요:

- CrowdStrike: AI 보안 및 침해 방지 분야에서 협업

- DataRobot, DataIQ, DataStax: AI 모델 배포 및 관리

- Elastic: 데이터 검색과 분석

- Nutanix, Red Hat: 가상화 및 인프라 환경 통합

- Trend Micro (타이완): 보안 인텔리전스 통합

이 파트너사들은 모두 엔비디아의 AI 라이브러리와 모델을 자체 플랫폼에 통합하고 있으며, 이를 통해 기업 내 AI 에이전트 운영을 가능하게 합니다.

🧑💼 AI가 만드는 새로운 조직 구조: HR for AIs

이제 정말 흥미로운 질문이 생깁니다. AI 에이전트가 기업 곳곳에서 일하게 되면, 누가 이들을 관리할까요?

바로 IT 부서가 새로운 HR 역할을 맡게 됩니다. 지금까지 HR이 사람을 관리했다면, 앞으로는 IT가 디지털 직원을 관리하는 거죠. 우리는 이를 위해 IT가 AI 직원의 관리자(HR)가 되는 구조를 만들고 있어요.

예를 들어, 한 기업의 IT 부서는 다음과 같은 역할을 하게 됩니다:

- 에이전트에게 어떤 업무를 맡길지 결정하고,

- 성능과 생산성을 평가하고,

- 필요 시 업그레이드나 교체를 진행하고,

- 협업 구조를 설계하며,

- 전반적인 ‘디지털 인사 운영’을 총괄합니다.

지금까지 우리는 컴퓨터를 더 빠르게, 더 똑똑하게 만드는 데 집중해왔어요. 그런데 이제는 컴퓨터가 팀원이 되는 시대가 열렸습니다. IT 조직은 더 이상 단순한 백엔드 엔지니어링 팀이 아니라, 디지털 인재를 운영하고 성장시키는 책임 조직이 됩니다. 그 중심에 있는 것이 바로 AI Ops입니다.

이제 우리는 에이전틱 AI(Agentic AI)라는 새로운 시대에 들어섰습니다. 여기서 말하는 ‘에이전트’는 단순히 질문에 대답해주는 AI가 아니에요. 이들은 인간처럼 다음과 같은 능력을 갖춘 디지털 직원입니다:

- 목표를 이해하고,

- 계획을 세우고,

- 정보를 찾고 도구를 사용하고,

- 다른 에이전트와 협력하며,

- 결과를 만들어내는 존재죠.

이 디지털 에이전트들은 단순한 자동화 스크립트가 아니라, 합리적인 사고와 판단을 바탕으로 행동하는 ‘디지털 동료’예요. 예를 들면 다음과 같은 역할을 수행할 수 있어요:

- 디지털 마케팅 캠페인 매니저

- 디지털 연구원

- 디지털 고객응대 매니저

- 디지털 코드 리뷰어

- 디지털 칩 설계 보조자

- 디지털 공급망 관리자 등

엔비디아는 이런 에이전트들이 실제 기업에서 운영될 수 있도록 인프라, 소프트웨어, 모델, API 전반을 모두 제공하고 있습니다.

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

📉 엔비디아 디지털 에이전트가 필요한 현실

전 세계는 심각한 인력 부족에 시달리고 있습니다. 2030년까지 약 3천만~5천만 명의 노동력 부족이 예상돼요. 이건 단순히 사람을 더 뽑는다고 해결되지 않는 문제예요. 그래서 기업들은 생산성 향상을 위해 디지털 인력의 활용을 필수적으로 고려하고 있습니다.

현재 엔비디아는 자사 엔지니어 전체가 AI 에이전트와 함께 일하고 있어요. 개발자가 코드를 작성하면, 에이전트가 먼저 리뷰하고 수정 제안을 하기도 하죠. 이처럼 사람과 AI가 함께 일하는 하이브리드 조직 구조가 점점 보편화될 겁니다.

🧠 엔비디아 에이전틱 AI의 작동 방식:

🧠 엔비디아 에이전틱 AI의 작동 방식:

에이전틱 AI는 다음과 같은 흐름으로 작동해요:

- 목표(goal)를 주면,

- AI는 이를 하위 목표로 분해(decompose)하고,

- 각 단계마다 계획을 세우고(reasoning),

- 필요한 도구(tool)를 호출하거나, 다른 AI와 협업하고,

- 최종 행동(action)을 실행합니다.

이 흐름은 우리가 로봇에서 말하는 이해 – 사고 – 행동의 루프와 같아요. 사실 에이전틱 AI는 디지털 형태의 로봇이라고 봐도 무방합니다.

🌎 앞으로의 조직 구조: 디지털 직원 + AI Ops = 새로운 기업

그럼 이런 AI 에이전트들이 조직 내에 도입되면 어떤 변화가 생길까요? 다음과 같은 새로운 조직 구조가 형성됩니다:

- 기업 내 HR은 사람 직원을 관리하고,

- IT 부서는 AI 직원을 관리하게 됩니다.

- AI 직원은 언제나 대기 중이며, 수십 개의 프로젝트를 동시에 수행할 수 있어요.

- 에이전트 간 협업도 가능하고, 업무 자동화가 아니라 ‘업무 수행’ 자체가 가능해집니다.

이런 구조가 만들어지기 위해서는 탄탄한 인프라와 더불어, 강력한 에이전트 소프트웨어, 잘 훈련된 모델, 그리고 이를 안전하게 관리할 수 있는 운영 체계가 필요하죠. 엔비디아는 바로 그 모든 층위에서 제품과 솔루션을 제공하고 있는 겁니다.

AI가 디지털 세계에서 목표를 이해하고, 계획하고, 실행하는 에이전트가 됐다면, 이제 우리는 현실 세계에서 움직이고 물리적으로 상호작용하는 AI, 즉 로봇을 준비해야 합니다. 이게 바로 Physical AI입니다.

🧠 Physical AI란 무엇일까?

Physical AI는 단순히 “움직이는 AI”가 아니에요. 이건 세상의 물리 법칙을 이해하고, 예측하고, 상호작용할 수 있는 지능입니다. 예를 들어:

- 공을 굴렸을 때, 그게 자동차 아래로 들어가면 반대편에서 나올 가능성이 높다는 걸 판단하거나,

- 앞에 테이블이 있으면 정면으로 뚫고 가는 게 아니라 옆이나 밑으로 돌아가는 게 낫다고 ‘추론’할 수 있어야 해요.

이게 바로 물리적 추론(physical reasoning)이며, 인간은 당연히 하는 이 사고를 AI도 학습하게 되는 거죠.

🐕 시뮬레이션에서 배우는 로봇들

엔비디아는 현재 물리 AI 학습을 위한 시뮬레이션 플랫폼을 개발하고 있어요. 이번 데모 영상에서는 단순한 애니메이션이 아닌 실제 물리 엔진 기반 시뮬레이션을 보여줍니다.

예:

AI에게 “강아지를 생성해줘. 새랑 함께 있는 장면도 보여줘”라고 프롬프트를 주면,

AI는 처음엔 정적인 이미지로 시작하고,

그다음에 이 장면에서 일어날 수 있는 일들을 물리적으로 시뮬레이션하기 시작해요.

공이 굴러가고, 강아지가 미끄러지고, 로봇이 모래 위를 걷다가 발을 헛디디는 상황까지.

이 모든 게 물리 법칙을 따르는 시뮬레이션으로 작동하는 겁니다.

🤖 로봇이 되기 위한 3단계 훈련 루프

- AI 모델을 학습시키는 컴퓨터 (Training with GB200, GB300)

- 시뮬레이션 환경에서 반복 훈련시키는 Omniverse 기반 로봇 시뮬레이터

- 학습된 AI를 실제 로봇에 이식해 배포 (Jetson Thor + Isaac platform)

엔비디아는 자율주행차에서 이 3단계 루프를 먼저 실현했고,

이제는 로봇 전반으로 확장하고 있어요.

🧪 로봇을 위한 시뮬레이션 물리 엔진: Newton

로봇이 실제처럼 배우기 위해선 시뮬레이션 엔진도 정교해야 합니다. 그래서 엔비디아는 DeepMind, Disney Research와 협력해 만든 새로운 물리 엔진 Newton을 공개했어요.

- GPU에서 완전 가속되고

- 미분이 가능해서 학습에도 적합하며

- 리지드 바디 + 소프트 바디(말랑한 재질)까지 완벽하게 구현 가능

이 엔진은 7월에 오픈소스로 공개될 예정입니다. 그리고 이미 MuJoCo나 엔비디아의 Isaac Sim 같은 플랫폼에도 통합될 예정이에요.

이제 로봇은 사람이 직접 프로그램하지 않아도, 시뮬레이션 안에서 스스로 배우고 성장할 수 있어요. 이런 로봇들은 가정에서, 공장에서, 물류창고에서, 의료 현장에서 활약할 수 있게 됩니다.

엔비디아는 지난 몇 년간 자율주행차에서 쌓은 경험을 바탕으로, 이제 로봇 산업 전반으로 기술을 확장하고 있습니다.

우리가 자율주행차를 만들 때도 3단계 루프를 썼어요:

- AI 모델을 대규모 시스템에서 학습 (GB200, GB300)

- Omniverse 기반 시뮬레이션 환경에서 테스트하고 훈련

- 완성된 AI를 실제 하드웨어에 배포

이제 이걸 로봇 전반에도 똑같이 적용하려는 겁니다.

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

🤖 Isaac Groot 플랫폼: 로봇의 학습과 실행을 위한 통합 플랫폼

이 모든 걸 하나로 연결해주는 엔비디아의 로봇 플랫폼이 바로 Isaac Groot입니다. Isaac Groot는 다음과 같이 구성돼요:

- Jetson Thor: 로봇에 탑재되는 강력한 AI 칩

- Isaac OS: 로봇을 위한 런타임 운영체제

- 사전 훈련된 모델과

- 로봇 학습 도구 전체를 포함한 프레임워크

Jetson Thor는 자율주행차용으로도 쓰이는 고성능 AI 칩인데, 이제 휴머노이드, AMR(자율이동로봇), 로봇팔 같은 일반 로봇에도 적용할 수 있어요.

Isaac OS는 센서 입력을 받아들여, 뉴럴 네트워크 추론을 실행하고, 그 결과를 통해 로봇의 관절이나 바퀴를 제어하는 역할을 합니다.

🌱 Isaac Groot N1.5 공개: 오픈소스 모델과 도구 전면 공개

이번 Computex에서 젠슨 황은 Isaac Groot N1.5를 오픈소스로 공개한다고 발표했습니다!

이미 6,000회 이상 다운로드됐고, 커뮤니티의 반응도 굉장히 뜨거워요.

Isaac Groot는 단순한 로봇 코드 저장소가 아니에요.

- 로봇이 사람의 동작을 따라 배우고

- 그걸 추상화해 다양한 상황에 응용할 수 있도록 설계돼 있습니다.

🎓 로봇 학습의 혁신: Groot Dreams

로봇을 훈련시키려면 무엇보다 데이터가 필요하죠.

하지만 현실에서 사람이 일일이 조작해 시범을 보여주는 건 비효율적이에요.

그래서 엔비디아는 AI가 AI에게 가르치는 구조,

즉 Groot Dreams라는 훈련 시스템을 개발했습니다.

이건 이렇게 작동해요:

- 사람이 텔레오퍼레이션으로 단 1번 로봇에게 시범을 보입니다.

- 그 과정을 AI가 보고 수천 가지 시뮬레이션을 생성해요.

- AI는 그 ‘꿈(Dream)’들 중에서 가장 퀄리티가 높은 시뮬레이션을 스스로 골라내고,

- 그것을 바탕으로 실제 로봇 행동을 학습시킵니다.

즉, 한 명의 사람이 수천 명 분량의 시범을 만들어낼 수 있는 시대가 열린 거예요.

이게 바로 AI의 AI화를 보여주는 강력한 사례예요.

AI가 데이터를 증식시키고,

AI가 로봇을 가르치고,

AI가 세상을 더 잘 이해하게 만드는 AI 생태계의 선순환이 시작된 겁니다.

로봇이 움직이는 세상, 그 세상 자체가 디지털로 재현된다면 어떨까요?

엔비디아는 현실 세계 전체를 시뮬레이션하는 기술, 즉 Omniverse 기반의 디지털 트윈을 통해

공장, 장비, 로봇, 건물, 심지어 도시 전체를 가상 환경에서 1:1로 구현하고 있어요.

🏭 엔비디아가 꿈꾸는 디지털 트윈

타이완의 대표 기술 기업들은 이미 Omniverse를 기반으로

자신들의 공장을 완전히 디지털 트윈으로 변환하고 있습니다:

- TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, WeWin, Gigabyte

→ 모든 제조 과정을 Omniverse 상에서 설계, 최적화, 시뮬레이션

예를 들어:

- TSMC + MetAI: 2D CAD 도면으로부터 전체 반도체 팹(Fab)을 3D 레이아웃으로 자동 생성

- Quanta, Wistron, Pegatron: 실제 착공 전, 공장 전체를 가상으로 계획해 수십억 원 절감

- Pegatron: 납땜 공정까지 시뮬레이션해서 결함률 감소

- Quanta: Siemens Teamcenter X와 Omniverse 연동으로 복잡한 제조 순서 최적화

- Foxconn, Quanta: 데이터센터의 냉각, 전력 효율 시뮬레이션까지 Omniverse로 수행

이 모든 디지털 트윈은 단순히 가상 시각화가 아니에요.

→ 실제 센서 데이터 + IoT와 연동돼 실시간 대시보드로 작동합니다!

🤖 로봇 훈련장으로도 활용되는 디지털 트윈

흥미로운 점은, 이 공장 디지털 트윈이 로봇의 훈련장이 되기도 한다는 것입니다.

- 각 기업은 Omniverse 위에서 자신의 로봇을 생성하고,

- 가상 환경에서 훈련시키며,

- 팀 단위로 함께 움직이는 로봇 플릿(fleet)을 시뮬레이션할 수 있어요.

로봇이 단독으로 행동하는 게 아니라,

공장 전체 프로세스 속에서 사람, 기계, 다른 로봇들과 함께 협업하는 환경이 만들어지는 거죠.

엔비디아가 발급해주는 공식 수료증 과정이 따로 있다고?

🌆 엔비디아, 도시도 디지털 트윈이 된다

Omniverse는 단순히 공장에만 적용되는 게 아니에요.

타이완 가오슝시는 도시 전체를 디지털 트윈으로 구현했어요.

- Linker Vision + 가오슝시

→ 도시 전체를 시뮬레이션하고,

→ AI 에이전트가 CCTV 스트림을 분석해 긴급상황을 즉시 파악하고 대응할 수 있어요.

이제 도시 전체가 AI와 로봇, 데이터가 연결된 실시간 시스템으로 작동하게 됩니다.

🏗️ 엔비디아, 전 세계 산업 재편과 디지털 트윈의 기회

현재 전 세계에서는 약 5,000조 원 규모의 신규 제조 공장이

앞으로 3년간 건설될 예정입니다.

→ 그 모든 공장이 디지털 트윈으로 시뮬레이션되고 최적화될 수 있어요.

뿐만 아니라, 기존 공장과 인프라, 심지어 엔비디아 본사의 AI 팩토리도

모두 Omniverse 기반의 디지털 트윈으로 만들어지고 있습니다.

“Kaohsiung is now a digital twin.”

가오슝은 이제 디지털 트윈입니다.

🎬 젠슨 황은 마지막으로 Omniverse 기반 디지털 트윈과 산업 재편의 기회를 강조하며,

이 기술이 단지 AI의 보조 수단이 아니라,

산업 전체를 재편하고, 미래를 설계하는 핵심 기술임을 분명히 했어요.

[젠슨 황]

제가 방금 소개한 이 모든 기술들—AI 팩토리, Agentic AI, 로봇, 디지털 트윈—

사실 이건 여러분이 만든 세상입니다.

여러분이 AI를 전 세계에 전파했죠.

그리고 이제, AI가 다시 여러분의 산업과 삶을 바꿀 차례입니다.

처음에 말씀드렸죠?

“GeForce가 AI를 세상에 소개했고,

이제 AI가 다시 GeForce를 혁신했다.”

이처럼 타이완의 기술 생태계가 세계를 AI 시대로 이끌었고,

그 AI가 다시 타이완을 변화시키는 중이에요.

✨ 엔비디아 Constellation: 대만에 들어설 엔비디아

이제 엔비디아는 타이완에서의 활동을 더 확장할 거예요. 그동안 함께 성장한 모든 파트너, 협력자들 덕분에 엔비디아도 더 많은 엔지니어와 함께 더 큰 꿈을 꿀 수 있게 됐어요.

그래서 오늘 공식 발표합니다.

새로운 엔비디아 타이완 본사, 이름하여 “엔비디아 Constellation”이

베이토우-스린(北投-士林) 지역에 지어집니다!

“우린 이미 부지를 확보했고, 시장님과도 협의를 마쳤어요.

여러분도 시장님께 전화해서 찬성한다고 꼭 말해주세요.” (웃음)

Constellation은 엔비디아가 타이완에서 펼칠

다음 세대 기술의 중심이 될 거예요.

단순한 사무실이 아니라, AI, 로보틱스, 제조, Omniverse가

모두 한데 모인 기술 별자리(별무리)가 될 겁니다.

“우리는 지금까지 IT 산업을 수차례 재창조해왔어요.

PC, 인터넷, 클라우드, 모바일 클라우드까지.

그런데 이번에는 완전히 새로운 산업을 만들고 있는 겁니다.”

젠슨 황은 그 산업을 AI 팩토리 산업,

그리고 디지털 에이전트/로봇/디지털 트윈 중심의 지능형 사회 기반 산업이라고 표현했어요.

그리고 여러분 모두를 향해 이렇게 말했죠:

“이 믿을 수 없는 여정에 함께해주셔서 감사합니다.

우리는 새로운 세상을 함께 만들고 있습니다.

이번 Computex, 정말 감사합니다.

Thank you. Thank you. Thank you.”

.

.

.

엔비디아가 주는 공식 수료증이 있다는 사실, 알고 있으신가요?

NVIDIA DLI Cohort 는

일정 기간동안 지정된 DLI 코스를 수강하고 기술 개발 역량을 쌓을 수 있는데요,

엔비디아에서 지급하는 수료증도 발급받을 수 있답니다.

관심 있으시다면 아래 이미지를 클릭해주세요 🙂

[출처] NVIDIA CEO Jensen Huang Keynote at COMPUTEX 2025